Recap ConversionSUMMIT 2014 – Das ConversionCAMP

Das conversionCAMP ist quasi eine Un-Konferenz im Open Space Stil und fand am Folgetag der conversionSUMMIT statt. Die Union Halle Frankfurts öffnete am 05.09.2014 ab 8:oo Uhr Ihre Tore. Für mich war das mein erster Fachbesuch auf einer Messe für takevalue. Ich durfte hier am zweiten Messetag sozusagen Jens vertreten, der am ersten Tag Gelegenheit hatte die Messe zu besuchen. Der zweite Tag der CS ist das conversionCAMP. Parallel finden in drei verschiedenen Räumen Sessions statt. Nach einem kleinen Frühstück und einer Begrüßung wurden die angebotenen Vorträge vorgestellt und auf die vorhandenen Räume aufgeteilt. Ich habe mich für folgende Sessions entschieden:

1. Statistik für Marketeer und Studienanwender (Thorsten Biedenkapp)

2. Marketing Automation (John Ekman)

3. Sitesearch und CRO (Peter Rieger)

4. Offsite Conversion Optimierung (Andreas Korsus)

5. Responsive/Apps und Mobile Websites (Felix)

1. Statistik für Marketeer und Studienanwender (Thorsten Biedenkapp)

Zum Auftakt des CMPS der conversionSUMMIT 2014 wählte ich das Thema Statistik für Marketeer und Studienanwender. Getreu dem Motto „Glaube keiner Statistik, die du nicht selbst gefälscht hast“ wurde hier von Thorsten Biedenkapp der Umgang mit Statistiken und Studien kritisch beleuchtet.

Als Aufhänger wurde eine vielzitierte Studie aufgegriffen, über die erst kürzlich in einigen Medien berichtet wurde. Unter anderem hat t3n bezüglich der Studie den Artikel „Studie seziert eine Million Headlines: Darauf springen Nutzer am häufigsten an“ veröffentlicht. Auch moz.com hat sich in dem Artikel „5 Data Insights into the Headlines Readers Click“ zu der Studie geäußert.

Wirft man einen näheren Blick auf die Erhebung wird schnell deutlich, dass hier sehr wenige Details angegeben werden: Welche Teilnehmer wurden befragt? Wie setzen sich die untersuchten Nutzer zusammen?

Ausgehend von der genannten Studie kam Thorsten Biedenkapp auf die Voraussetzungen für ein gutes Studiendesign zu sprechen.

Als Grundvoraussetzung, um eine gute Studie durchführen zu können, werden zunächst einmal gute Daten benötigt. Weiterhin sollte die Studie auch bei mehrmaliger Anwendung immer die gleichen Ergebnisse erzeugen (Reliabilität). Die durchgeführten Messungen sollten valide sein, also dem entsprechen, was in der Arbeitshypothese beschrieben wird. Wirtschaftliche und politische Interessen haben hier nichts verloren. Vor allem sollte eine gute Studie transparent und überprüfbar mit den erhobenen Daten umgehen. Hierzu müssen natürlich auch relevante Daten genannt werden, die eine Überprüfung der Ergebnisse ermöglichen. Dies ist, wie auch in dem eingangs erwähnten Beispiel, jedoch häufig nicht der Fall.

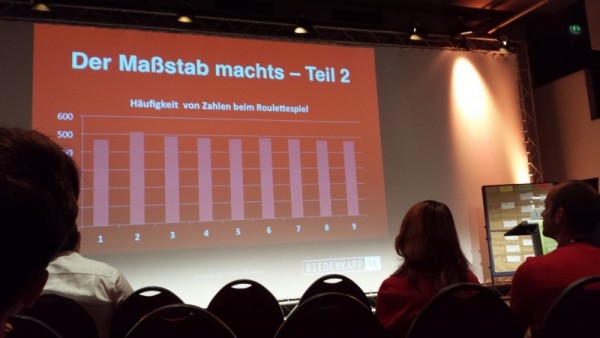

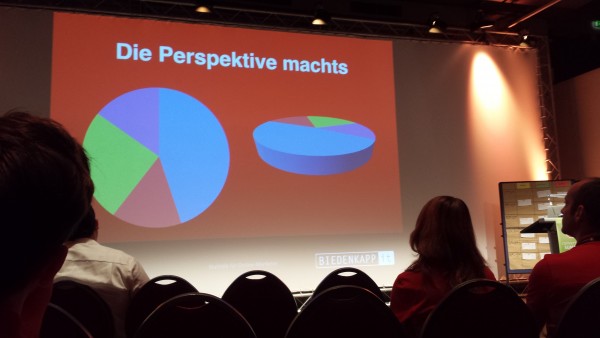

Als nächstes ging Thorsten Biedenkapp mit einigen Beispielen auf die Darstellung von Daten ein, mit der maßgeblich die Wahrnehmung beeinflusst werden kann. Auch wenn dies zunächst banal anmutet, ist es dennoch gängige und wirkungsvolle Praxis, zum Beispiel durch an die Darstellung angepasste Maßstäbe, Wertebereiche oder die Skalierung von Achsen die Daten so zu visualisieren, dass sie von den Rezipienten der Studie als passend (oder passender) zur gewünschten Aussage wahrgenommen werden. Hierzu gab es auch einige anschauliche Beispiele:

Der Maßstab machts: Je nach Wertebereich der Achsen lassen sich die gleichen Daten völlig unterschiedlich darstellen. Banal, aber wirkungsvoll!

Selbst durch die Perspektive lassen sich Darstellungen einfach verfremden.

In vielen Studien ist unklar, aus welchen Teilnehmern oder Daten sich die Zielpopulation/Grundgesamtheit, die untersucht werden soll, zusammensetzt. Werden Stichproben untersucht, so muss die Stichprobe die Zielpopulation im kleinen Maßstab abbilden. Oft werden jedoch schon bei der Auswahl der Stichproben grobe Fehler begangen. Als anschauliches Beispiel erzählte Thorsten Biedenkapp hier von eigenen Erfahrungen, die er persönlich in der Fußgängerzone in Frankfurt „auf der Zeil“ bereits gesammelt hat. Allein durch die Art der Fragestellung, die bevorzugte Auswahl von bestimmten Personengruppen oder auch durch Manipulation des Fragebogens seitens des Fragenden, um notgedrungen die eigene Quote zu erfüllen, schleichen sich während der Erhebung oft zahlreiche Fehler ein.

Teilweise werden auch geradezu lächerlich geringe Stichproben erhoben. Auch hierzu gab es einige erheiternde Beispiele in der Form „88% der Testerinnen bewerteten die XYZ Creme als sehr gut“. Befragt wurden für diese Studie 100 Leserinnen einer Frauenzeitschrift. Abgesehen von einem Bias bei der Auswahl der Teilnehmer wird bei solchen „Studien“ natürlich eine viel zu geringe und nicht repräsentative Stichprobe erhoben.

Als ungefähren Wert für die Fehlergrenze von Stichproben gab Thorsten Biedenkapp dem Zuhörer noch die Faustformel 1/Wurzel(n) mit. Bei 100 befragten Personen bekommt man hier einen Wert von circa 0,1 heraus. Die erhobenen Werte sind also in etwa mit einer Genauigkeit von +/- 10% zu deuten.

Bei Fehlern in den Erhebungsdaten (zum Beispiel falsche oder fehlende Angaben bei dem Feld „Alter“ in einer Befragung) werden fehlerhafte Daten oft einfach verworfen und in der Auswertung unterschlagen. Eine korrekte Studie dokumentiert solche Fehler und stellt sie in der Auswertung mit dar.

Einen Lacher im Publikum hatte Thorsten Biedenkopp mit einem weiteren Beispiel auf seiner Seite: Ein Medikament wird vor seiner Markteinführung am Patienten getestet. In der Studie wird geschrieben: „Von den Patienten, die erfolgreich an der Studie teilgenommen haben…“.

Problem: Was ist mit den Patienten passiert, die nicht erfolgreich an der Studie teilgenommen haben? Sind sie vielleicht nach Einnahme des Medikaments verstorben?!

Es wird zumindest nicht genannt, welche Voraussetzungen für eine „erfolgreiche“ Teilnahme erfüllt sein müssen. Je nach angelegten Kriterien lässt sich das Ergebnis solcher Erhebungen maßgeblich beeinflussen. Um solch ein Ergebnis wirklich bewerten zu können, müssen die Voraussetzungen bekannt sein.

Ein weiterer Bias kann durch Suggestivfragen entstehen: „Sicherlich sind sie nach der Bestellzusammenfassung zur Kasse gegangen?“, oder „80% unserer Kunden sagen, dass wir ein gutes Warenangebot haben. Stimmen sie zu?“. Die besten Ergebnisse erhält man mit offenen Fragen, die am aufwändigsten auszuwerten sind. Auch der Zeitpunkt einer Studie kann das Ergebnis maßgeblich beeinflussen. Beispiel: Eine Umfrage zur Vertrauenswürdigkeit direkt nach einem Datenskandal des Anbieters.

Auch die zur Verfügung stehenden Bewertungsskalen können das Ergebnis beeinflussen. Die beliebte 5-Sterne Bewertung bei Panel-Umfragen weisen häufig eine Mitteltendenz auf: Oft werden 2 oder 3 Sterne vergeben. Als geeigneter erweisen sich hier 10 Punkte Skalen oder die Reduktion auf ein binäres Rating („Daumen hoch“/„Daumen runter“), um eine aussagekräftigeres Rating zu erhalten.

Zusammenfassend sollte also bei einer guten Studie auf folgende Punkte geachtet werden

- Das Studiendesign sollte objektiv, reliabel und valide sein

- Zahlen und Diagramme sollten auf Korrektheit überprüft werden (Addition, Maßstab, Perspektive)

- Zielpopulation und Stichproben sollten hinterfragt werden

- Umgang mit den Daten hinterfragen: Auslassungen, Antwortquote, Formulierungen

- Fragetypen und der Zeitpunkt der Studie sollte beachtet werden

Ehrlichkeit in einer Studie sollte immer höher honoriert werden als der Sensationsfaktor.

In der anschließenden Diskussionsrunde kam das Beispiel vom Spinat und dessen Eisengehalt auf. Lange Zeit galt als Common Sense, dass Spinat einen sehr hohen Eisengehalt aufweise. Dass dieser Irrtum nur aufgrund eines Kommafehlers entstand und jahrelang nicht entdeckt wurde, gilt als Paradebeispiel für Studien, deren Ergebnisse nicht kritisch hinterfragt oder überprüft werden. Statt einschlägige Studien wieder und wieder nachzubeten, sollte also immer ein kritischer Blick auf die Daten geworfen werden, um die Resultate selbst beurteilen zu können.

Zum Thema Fehlerrate wurde ein Beispiel aus der Praxis bezüglich Conversion-Messungen diskutiert. Ein Reporting betrachtet als Beispiel das Segment „wiederkehrende Besucher“, und berichtet einen Uplift von 10%. Bei einer kleinen Grundgesamtheit der Messung liegt die Fehlerquote hier möglicherweise über den gemessenen 10% Uplift. Die Werte werden dennoch als Erfolg verkauft.

Auch der Interessenkonflikt „Lange Fragebögen vs. Nutzerausstieg“ wurde diskutiert. Das Marketing möchte oft möglichst viele Fragen unterbringen. Je länger der Fragebogen, desto eher steigt der Nutzer jedoch während der Bearbeitung aus. Auch abgebrochene Fragebögen sollten dokumentiert werden, statt die Daten unter den Tisch fallen zu lassen. Sinnvoll ist es hier, demographische Daten am Ende abzufragen, da der Nutzer hier häufig aus der Umfrage aussteigt und abbricht.

Auch kam die Frage nach Best Practices bei der (Bestands-)Kundenbefragung auf. Hier kann bereits durch die Art des Incentives ein Bias entstehen. Als Beispiel wurde ein Amazon Gutschein von 10 EUR genannt. Der Gutschein führte im genannten Beispiel offensichtlich dazu, dass hauptsächlich IT´ler an der Umfrage teilnahmen. Umfragen sollten also nur dann mit Incentives belohnt werden, wenn sich eine ausreichende Teilnahme nicht anders erreichen lässt.

Der einstündige Vortrag „Statistik für Marketeer & Studienanwender“ war ein kurzweiliger und informativer Einstieg zum ConversionCAMP in der Union Halle in Frankfurt.

2. Marketing Automation (John Ekman)

Als nächstes besuchte ich den Vortrag von John Ekman (conversionista!) zum Thema Marketing Automation. Hier wurden Probleme angesprochen wie das fehlende direkte Nutzerfeedback. Der Vortrag entwickelte schnell sich zu einer angeregten Diskussion. Ich entdeckte Michael Janssen (Zedwoo) im Publikum, der bezüglich E-Mail-Marketing einwarf, dass hier durch die gegebenen Tracking-Möglichkeiten (Beispiel: Nutzer liest/klickt die Emails nicht mehr) durchaus ein implizites Nutzerfeedback besteht. Es wurde die Frage nach dem richtigen Maß im Marketing diskutiert. Beim Telefon-Marketing lässt sich der Nutzer direkt befragen, ob er mit weiteren Anrufen einverstanden ist. Beim E-Mail-Marketing ist dies nur durch das Messen des Nutzerverhaltens über ein Tracking möglich, wobei die Resultate hier zunächst gedeutet werden müssen.

Als weitere Möglichkeit, den Nutzer bei seinen Bedürfnissen abzuholen, könne dem Nutzer ein Bewertungssystem in der E-Mail/dem Newsletter angeboten werden. Um den Nutzer wirkungsvoll abholen zu können, ist eine crossmediale Ansprache in vielen Fällen empfehlenswert.

3. Sitesearch und CRO (Peter Rieger)

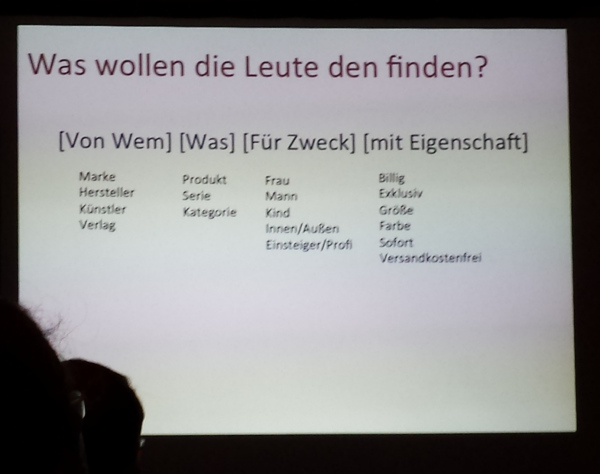

Nach der Mittagspause ging es gekräftigt in den nächsten Vortrag. Ich entschied mich für die Session Sitesearch und CRO. Peter Rieger (esemos.de) warb hier für die Seitensuche als Baustein der Conversion Rate Optimierung.

Nutzer, die eine interne Seitensuche verwenden, konvertieren wesentlich häufiger als die Nutzergruppe, die keine Sitesearch verwendet. Während die Ausgaben für das Nutzen der Sitesearch häufig gegen Null gehen, lagen die SEA Ausgaben in dem angeführten Beispiel im 5-6stelligen Bereich.

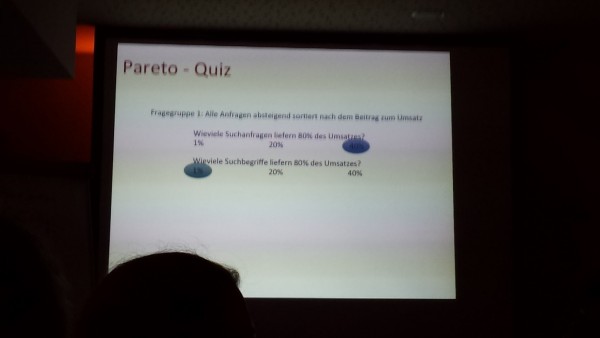

Peter Rieger startete nun ein kleines Quiz bezüglich der seiteninternen Suche mit seinem Publikum.

Zusammenfassend ergaben die Fragen und Antworten folgendes

- 40% der Suchanfragen liefern 80% des Umsatzes eines Unternehmens

- 1% der Suchbegriffe liefern 80% des Umsatzes

- 20% der meistgenutzten Anfragen liefern 15% des Umsatzes

- 20% der meistgenutzten Suchbegriffe generieren 45% des Umsatzes

- 1 Promille der eingegebenen Suchbegriffe liefert keine Suchergebnisse

Eine nähere Betrachtung und das optimieren der seiteninternen Suche erweist sich als wertvolle und effiziente Optimierungsmaßnahme. Werden eher Brands, Produkte oder generische Suchbegriffe eingegeben? Anhand der Suchanfragen lassen sich häufig gesuchte Themen prominenter im Menu und auf der Seite platzieren.

Weitere Learnings

- Bei den Suchvorschlägen (Autovervollständigung) die Umsatzstarken Begriffe in den Vordergrund bringen

- SEA und SEO mit den häufig verwendeten Suchbegriffen abgleichen. Hier können die Ergebnisse sehr gut als Inspirationsquelle für SEA und SEO verwendet werden

- Der Einbau von Synonymen und Korrekturvorschlägen in die Suche ist lohnenswert, muss jedoch immer individuell implementiert werden

- Eine unscharfe Suche ist relativ unwichtig. Es sollte besser auf gute Suchvorschläge bei der Autovervollständigung gesetzt werden

Die Menüstruktur sollte von generisch zu spezifisch gestaltet sein, die After Search Navigation hingegen von spezifisch zu generisch.

Die After Search Navigation wurde am Positiv-Beispiel von Conrad Electronic gelobt. Hier lassen sich nach der Suche die Ergebnisse in der Sidebar nach weiteren Kategorien wie dem Preis weiter filtern.

Abschließend wurde den interessierten Zuhörern noch als Empfehlung mitgegeben, die Artikel-Indexierung unbedingt von Hand durchzuführen, statt dies von einem Crawler erledigen zu lassen. Mit der Indexierung steht und fällt schließlich die interne Seitensuche.

4. Offsite Conversion Optimierung (Andreas Korsus)

Direkt im Anschluss lauschte ich dann dem Vortrag von Andreas Korsus (gastro-hero.de), der sich dem Thema Offsite Conversion Optimierung widmete. Als erheiterndes Beispiel für starke Offsite Maßnahmen nannte er den Sender QVC. Als auf dessen Webseite der Bilderserver ausfiel, war kaum ein Umsatzrückgang zu verzeichnen. Die Leute kauften die Produkte auch ohne entsprechendes Produktbild, da die Kaufentscheidung bereits vor dem Besuch der Webseite gefallen war. Statt sich nur auf die Kaufphase in der CRO zu konzentrieren, sollte der Kunde fortlaufend motiviert werden. Auch der Wiederverkauf, also die Bestandskundenpflege wurde als sehr wichtig herausgestellt.

Oft werde bei dem Planen von Display Werbung die Frage gestellt, ob der Werbende Branding oder Abverkauf wünsche. Eigentlich sollte hier nicht differenziert werden. Um den Kunden zum Kauf zu motivieren, muss „Relevanz, Vertrauen, Stimulanz, Sicherheit“ geschaffen werden. Danach ist der Kunde gewöhnlich erst bereit zum Kauf.

Cross Device Tracking wurde als sehr wichtig herausgestellt. Oft schaut sich ein potentieller Kunde Artikel mobil an und tätigt den Kauf dann später vom Desktop aus. Hier bietet sich aus der Praxiserfahrung heraus ein Facebook Pixel als beste Möglichkeit an den Nutzer Browser- und geräteübergreifend zu tracken.

5. Responsive/Apps und Mobile Websites (Felix)

Last but not least folgte ich der Session von Felix (windeln.de). Der Vortrag Responsive/Apps & Mobile Websites war eher als Diskussion angelegt. Felix berichtete von den ersten Erfahrungen mit Responsive Design bei windeln.de. Zunächst gab es eine iPhone App. Es sollte jedoch eine mobile Webseite entstehen. In der neuen App lief die mobile Webseite dann in einem Container. Der Relaunch war erfolgreich.

Als nächstes wurde über unterschiedliche Geräteanforderungen diskutiert. Auch ein Tablet hat spezifische Anforderungen an eine Website, auch wenn die Auflösung zum Teil eine normale Seitendarstellung erlaubt. Die Navigationselemente sollten auf Touch-Bedienung angepasst werden. Effekte wie Mouseover sind auf einem Tablet nicht nutzbar und müssen anderweitig umgesetzt werden.

Felix wandte sich nun an das Publikum und fragte, wie man es selbst mit mobilen Websites halte. Wird Responsive Design genutzt? Gibt es eine eigene Code Version für Mobile und Desktop? Es stellte sich heraus, dass sich jeder individuell mit dem Thema befasste, und die Teilnehmer durchaus unterschiedlich mit dem Thema Mobile Websites umgehen.

Die Reduktion der Mobile Website im Sinne der Usability wurde von Felix am Beispiel von windeln.de als äußerst wichtig herausgestellt. Der Warenkorb sollte geräteübergreifend gespeichert werden können. Der Mobile Traffic auf windeln.de liegt laut Felix inzwischen bei beeindruckenden 40%.

Abschließend gab es im Rahmen der Diskussion noch den Hinweis, dass inzwischen auch extrem hochauflösende Displays immer häufiger im Einsatz sind, und auch diese bei der Optimierung mit berücksichtigt werden sollten.

Ihr habt Fragen oder wollt noch mehr erfahren, dann schreibt uns einfach an unter: [email protected]. Wir freuen uns auf Eure spannenden Ideen.