SEOkomm 2015 Recap – SEO, Contentpflege, Crawling und mehr

Am 19. und 20.11. fanden in Salzburg wieder einmal die beiden Konferenzen OMX und SEOkomm statt. Beide Veranstaltungen genießen einen sehr guten Ruf und überzeugen mit namhaften und renommierten Speakern.

So wurde es Zeit für mich, nach einer längeren Konferenzpause nach Salzburg zu schauen und mich vor Ort von der Qualität zu überzeugen.Vorab kann ich schon einmal sagen, dass sich der Besuch definitiv gelohnt hat und ich es jedem Online Marketer und SEO nur empfehlen kann, im kommenden Jahr nach Salzburg zu reisen. Beide Konferenzen sind in der Tat sehr gut besetzt und die Veranstaltungen sind bestens organisiert.

Im Folgenden berichte ich genauer über die SEOkomm, den Recap zur OMX von meinem Kollegen Peter gibt’s hier.

Inhalt

- „Prozessoptimierung für SEO Agenturen“ – Sebastian Erlhofer

- „Digitale Geschichten über Lippenstift, Duschgel & Co.“ – Manuela Schöpfer

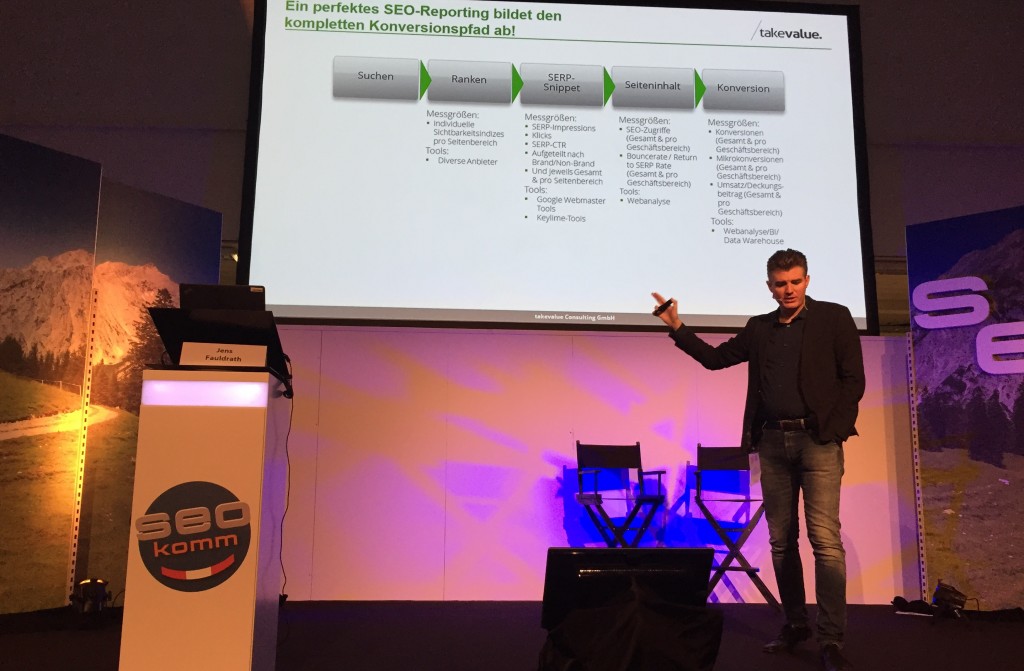

- „SEO Controlling“ – Jens Fauldrath

- „Keyword-Skalierung“ – Bernhard Ollefs

- „Google antwortet“ – John Müller

- „Screaming Frog Tricks, die du noch nicht kanntest“ – Mario Träger

- Fazit

Grundsätzlich gibt es bei der SEOkomm drei parallel laufende Streams: Grundlagen, Strategie und Hardcore.

In erster Linie waren für mich die Hardcore- & Strategie-Sessions wichtig. Dementsprechend begann der Tag nach der Keynote von Marcus Tandler mit dem Vortrag „Prozessoptimierung für SEO Agenturen“ von Sebastian Erlhofer.

„Prozessoptimierung für SEO Agenturen“ – Sebastian Erlhofer

Dass Sebastian bereits seit zwölf Jahren im Agenturgeschäft unterwegs ist, merkte man schnell. Er berichtete von den unterschiedlichen Prozessen, die sowohl intern (Team, Weiterbildung, Personalmanagement, Einkauf usw.) als auch extern (Reporting, Reputationsaufbau etc.) abgebildet und optimiert werden müssen.

Doch was genau bringt die Optimierung von Prozessen? Sebastian Erlhofer sagt dazu Folgendes:

- Qualität – erhalten und erhöhen

- Effektivität – richtiger Output zur richtigen Zeit am richtigen Ort zum richtigen Preis

- Effizienz – optimale Nutzung von Ressourcen

- Happyness – Erwartungen sind synchronisiert

- Innovation – Raum für Innovation schaffen

- Kreativität – Klarheit in den Prozessen schafft Sicherheit und bietet Platz für Kreativität

„Raum und Zeit schaffen, um an Prozessen arbeiten zu können.“

Um das zu erreichen, ist es natürlich von essentieller Bedeutung Raum und Zeit zu schaffen, um an den eigenen Prozessen arbeiten zu können und neue Prozesse zu etablieren. Das lässt sich unter anderem dadurch erreichen, dass man bereits neue Mitarbeiter einstellt, bevor die Auslastung zu hoch wird.

Anschließend ist es wichtig, diese Mitarbeiter für Prozesse zu sensibilisieren, sie an der Prozessentwicklung teilhaben zu lassen und sich sowohl mit einzelnen Mitarbeitern als auch im Team regelmäßig auszutauschen und somit gezielt Gelegenheiten zu schaffen, um Prozesse auch zu diskutieren.

Denn wenn ein Prozess überholt ist, überflüssig wird oder berechtigterweise nicht mehr eingehalten wird, muss man einen Prozess auch wieder abschaffen!

Ein weiterer wichtiger Punkt war die Integration eines Know-How-Transfers in die internen Prozesse einer Agentur. Auch wir merken fast täglich, wie wichtig es ist, dass die einzelnen Mitarbeiter ihr Wissen mit dem Team teilen. Nur so kann langfristig eine hohe Arbeitsqualität und ein stetiger Know-How-Zuwachs sichergestellt werden.

Alles in allem ein äußerst gelungener Vortrag, aus dem auch wir bei /takevalue noch die ein oder andere Anregung mitnehmen konnten und demnächst bestimmt auch bei uns im Team etablieren werden.

„Digitale Geschichten über Lippenstift, Duschgel & Co.“ – Manuela Schöpfer

Gleich im Anschluss durfte ich Manuela Schöpfer von dm Österreich lauschen. Sie erzählte digitale Geschichten über Lippenstift, Duschgel & Co. – ein sehr unterhaltsamer und runder Vortrag, wie ich fand.

Es war sehr spannend zu erfahren, wie man bei dm Österreich die überwiegend weibliche Zielgruppe mit einer aufwändigen Produktinszenierung und gezieltem Content Marketing zu erreichen versucht. Dabei scheint bei dm die Verbindung von Offline und Online sowie die Verknüpfung der unterschiedlichen Online Marketing-Kanäle sehr gut zu gelingen.

So sind beispielsweise die Redaktionen der Online-Abteilung und der Print-Abteilung sehr gut miteinander verknüpft und holen sich gegenseitig Inspiration für ihre Inhalte. Darüber hinaus gehen die Online-Mitarbeiter auch in die Ladengeschäfte und sprechen dort direkt mit dem Personal, um sich Feedback zu den aktuellen Nutzerbedürfnissen vor Ort einzuholen.

Im Gegenzug werden inzwischen auch in den Ladengeschäften Produktrezensionen aus dem Online Shop an den Produktregalen platziert, um dem Kunden auch vor Ort einen Mehrwert zu bieten.

Bei dm sieht man den Online Shop also als logische Ergänzung zu den lokalen Geschäften und Manuela sprach in Bezug auf den Online Shop von einem „großen digitalen Schaufenster für die Kunden“. Das bestätigt auch die Verweildauer der Kunden im Online Shop von über vier Minuten.

Und auch bei Karl Kratz scheinen die Mitarbeiter aufmerksam zugehört zu haben. Manuela berichtete, dass man bei dm Österreich Newsletter etabliert hat, die auf spezifische Zielgruppen angewendet werden und immer wieder zum Einsatz kommen. Somit macht sich der hohe Erstellungsaufwand bezahlt und die Inhalte können auch mit geringen Kapazitäten fortlaufend optimiert werden. Als Beispiel wurden junge Eltern genannt, die per Newsletter immer die passenden Angebote für das Alter ihres Kindes erhalten.

„SEO Controlling“ – Jens Fauldrath

Im Anschluss war dann unser Geschäftsführer Jens an der Reihe. Ich war wie immer begeistert, die detaillierten Informationen zu seinem Vortrag kann man aber am besten an anderer, neutraler Stelle lesen.

„Keyword-Skalierung“ – Bernhard Ollefs

Weiter ging es danach mit dem Thema „Keyword-Skalierung“ von Bernhard Ollefs, der sich bereits seit den Anfangstagen von Zalando und später bei Witt intensiv mit dem Thema Online Shop-Optimierung beschäftigt.

Hier war es schön zu erkennen, dass die Optimierung großer Shops zwar eine herausfordernde und komplexe Arbeit ist, jedoch auch keine große Magie. Vielmehr ist solides Handwerk erforderlich, um seine Inhalte zu vielen nachgefragten Begrifflichkeiten in den Suchmaschinen zu platzieren.

Die folgenden vier Phasen nannte Bernhard Ollefs:

- Keyword-Kern Skalierung – Content auf den Bestandsseiten ausbauen und optimieren

- Filter ausreizen – nachgefragte Filterkombinationen für Suchmaschinen indexierbar machen und diese Seiten optimieren

- Glossar – weitere Suchanfragen, die nicht über den Kategoriebaum bedient werden, können in Form eines Glossars o.ä. bedienen

- Magazin – Content rund um das Produktangebot aufbauen

Letzen Endes geht es im Prinzip also darum, die technische und inhaltliche Basis im Online Shop zu schaffen, um skalieren zu können. Im Anschluss sollte man dann neben den Kerninhalten im Zuge einer Contentstrategie auch die für die Zielgruppe relevanten Themen besetzen, um eine frühzeitige Kundenbindung zu erzielen.

Ein schönes Beispiel dafür findet man beim umfangreichen Schwangerschaftskalender von windeln.de, der die werdenden Eltern bereits während der Schwangerschaft begleitet, mit der Absicht, diese schließlich auch als Kunden zu gewinnen. Jedoch wird dabei auch schnell deutlich, dass die Durchführung einer solchen Strategie mit viel Aufwand verbunden ist. Hier wäre die eine oder andere betriebswirtschaftliche Kennzahl bestimmt noch sehr interessant gewesen.

„Crawl Budget Best Practices“ – Jan Hendrik Merlin Jacob

Genug von Strategie. Danach ging’s zum Hardcore-Panel von Merlin Jacob, der etwas über die Optimierung des Crawl Budgets zu erzählen hatte. Inhaltlich definitiv einer der interessantesten Vorträge.

Merlin griff dabei auch das Thema AngularJS kurz auf, welches uns im Arbeitsalltag zuletzt immer häufiger begegnet. Er erklärte, welche Herausforderung diese Framework-Lösung für Google darstellt und wie dabei die Notwendigkeit, identische Inhalte mehrmals abfragen zu müssen, das Crawling-Budget ganz schön strapazieren kann.

Wie schaffe ich es also, das Crawling Budget auf meiner Seite zu optimieren und was beeinflusst es negativ? Diese Fragen beantwortete Merlin und gab wertvolle Tipps für Webmaster, ihre Inhalte zu optimieren.

Duplicate Content verursacht Abbrüche beim Crawling

Hiermit lieferte er wohl DAS Argument, Karl Kratz zu folgen und die eigene Website von Ballast zu befreien: Thin Content oder doppelter Content ist direkt verantwortlich für hohe Abbruchquoten beim Crawling.

Das bedeutet: Biete ich Google nur Duplikate (Paginierungen, leere Seiten, mehrfach die gleichen Inhalte unter verschiedenen URLs) oder nur äußerst spärlich befüllte Seiten, die inhaltlich nicht viel zu bieten haben, lässt der Bot es einfach irgendwann bleiben oder kommt sehr viel seltener und dann auch noch kürzer vorbei.

Hier sollten Betreiber großer Webprojekte definitiv die Ohren spitzen und dringend den notwendigen Handlungsbedarf erkennen. Trennt euch von euren Duplikaten und schlechtem Content!

Relevante Seiten werden häufiger gecrawlt

Eine kleine Hilfe für Webmaster zur Bestimmung der Relevanz einer Seite ist die Distanz einer Seite zur Homepage. Wird diese zu groß (also Klicktiefe des Nutzers), leidet darunter auch das Crawling.

Seiten, die häufig intern wie extern verlinkt sind, werden ebenfalls sehr viel häufiger gecrawlt als andere Seiten. Google startet keineswegs immer bei der Startseite, sondern viel öfter bei ebendiesen gut verlinkten Seiten.

Google berücksichtigt den „if modified since“-Header

Durch die Erweiterung des Headers um if modified since kann man Google mit dem ersten Crawl einer Seite mitteilen, ob sich die Inhalte geändert haben. Google schickt, nachdem bekannt ist, dass man diese Information bereitstellt, bei jeder erneuten Anfrage das alte Datum mit. Hat sich nichts geändert, antwortet mein Server mit 304 (not modified) und schickt auch kein body Element mehr mit. Dies spart nicht nur Crawl-Budget, sondern auch Bandbreite!

Ebenso kann man auch über die XML-Sitemap die Information bereitstellen, wann sich der Inhalt einer Seite zuletzt geändert hat. Leider wird auch diese Möglichkeit noch zu selten von Website-Betreibern genutzt.

„Google antwortet“ – John Müller

Auch John Müller von Google griff das Thema AngularJS im Anschluss nochmals auf. Er bestätigte, dass Google höhere Aufwände mit dem Crawling von Javascript hat, berichtete aber auch, dass das JS-Crawling bei Google weiterhin vorangetrieben wird.

Nicht unerwähnt blieb an dieser Stelle auch, dass der Einsatz von Javascript basierten Framework-Lösungen auch abseits von Google zu großen Problemen führen kann, da auch Facebook & Co. diese Inhalte nicht verarbeiten können und somit z.B. auch sehr unsaubere Darstellungen beim Teilen von Inhalten auf Facebook die Folge sein können.

Nach dieser kurzen Einführung stellte John sich den Fragen des Publikums zu Google Translate, Hreflang, Rich Snippets und einigem mehr. So erfuhren die Anwesenden, dass auch bei Google iPhones im Einsatz sind 😉

Eine der spannendsten Fragen war die Weiterentwicklung der Google Search Console. Leider wollte John sich ausgerechnet dazu nicht weiter äußern und verriet lediglich, dass definitiv etwas geplant sei.

„Screaming Frog Tricks, die du noch nicht kanntest“ – Mario Träger

Den Abschluss eines spannenden Konferenztages bildete Mario Träger, der dem, trotz später Stunde doch noch sehr zahlreich anwesenden, Publikum einige interessante Details zur Nutzung des Screaming Frogs vorstellte. Auch bei uns ist dieses Tool sehr intensiv im Einsatz und viele meiner Kollegen sind damit auch bestens vertraut. Für mich hat sich an dieser Stelle aber noch einmal verdeutlicht, dass es an der Zeit ist, mich wieder intensiver mit dem Frosch zu beschäftigen.

Indexierungskontrolle

Schaut man in die GSC und stellt fest, dass der Anteil der indexierten Seiten stark von der Anzahl der über die XML-Sitemap eingereichten URLs abweicht, so kann man mit Hilfe des Screaming Frogs genauer analysieren, woran es liegen kann. An dieser Stelle möchte ich drei Beispiele nennen:

- Seiten liefern einen 404 Status

- Seiten beinhalten ein fremdverweisendes Canonical-Tag

- Seiten sind zu tief in der Hierarchie verortet und werden zu wenig verlinkt

Duplicate Content identifizieren

Neben den Informationen, die einem die GSC an Hand der doppelten Titles und Descriptions liefert, kann auch hierbei der Frosch noch weitere Informationen liefern. So lassen sich beispielsweise über Customer Extractions alle Produkttexte eines Online Shops crawlen, man kann sich den Text zurückgeben lassen und schließlich identifizieren, wo identische Texte verwendet werden.

Unterstützung beim Relaunch

Relaunches stellen einen Anwendungsfall dar, für den auch wir regelmäßig den Screaming Frog nutzen. Neben der grundsätzlichen Möglichkeit, die bestands-URLs vor einem Relaunch zu identifizieren und anschließend Weiterleitungsziele zu definieren, die dann nach dem Relaunch überprüft werden können, lassen sich auch Weiterleitungsketten auffinden, die in diesem Zuge auch gleich bereinigt werden können.

An dieser Stelle hatte Mario auch noch einen Tipp für den Fall, dass kein Crawl der Website im Vorfeld eine Relaunchs erfolgt ist: Einfach die Waybackmachine crawlen! Das ist immerhin besser, als gar keine Daten vorliegen zu haben.

Bewertung von Backlinks

Ein weiterer Anwendungsfall für den Scremaing Frog ist die Bewertung von linkgebenden Seiten. Hierzu sollte man möglichst alle Backlinkquellen anzapfen, die Daten sammeln und die URLs schließlich crawlen lassen. Anschließend kann man die einzelnen Seiten z.B. auf Thin Content hin untersuchen oder hinsichtlich der Anzahl der ausgehenden Links (Linkspam) auf einer Seite bewerten.

Fazit

Salzburg ist eine Reise wert! Ob mit oder ohne Weiterbildung, sollte man sich einen Besuch in der Mozartstadt gönnen. Lässt sich dieser Besuch jedoch terminlich mit der SEOkomm vereinbaren, sollte man sich das nicht entgehen lassen.

Vielen Dank an dieser Stelle an die Organisatoren Oliver & Uschi Hauser!

Rein inhaltlich betrachtet war es nach längerer Zeit ohne Konferenz schön für mich zu erfahren, dass die eigene Arbeit, wie man ihr täglich nachgeht, genau in der Form absolut richtig ist und SEO immer noch ein grundsolides aber auch sehr spannendes und herausforderndes Handwerk ist.

Auch spannend