Recap SEO CAMPIXX – Tag 2 von David

Der erste Tag der SEO CAMPIXX war in Sachen Vortragsqualität und Networking wirklich großartig. Wie Patrick auch schon in seinem Recap geschrieben hat, sind deshalb auch unsere Recaps des ersten Tages sehr umfangreich ausgefallen. Nach den tollen Eindrücken des ersten Tages waren wir sehr gespannt auf Tag 2.

Tag 2

- SEO-Agentur goes Google AdWords Partner – Sven Deutschländer

- Crawling-Analyse: Wo ver(sch)wendet Google Crawling-Ressourcen? – Stephan Czysch

- Semantic Search: SEO, Marketing and Content for the Future – Svenja Hintz

- Mehr zur SEO CAMPIXX 2014

SEO-Agentur goes Google AdWords Partner – Sven Deutschländer

Leider fiel die Session „Local SEO Tools, Kunden, Traffic. Wie funktioniert es?“ nach Auskunft einiger Teilnehmer aus, weshalb ich leider mit kleiner Verspätung in der Session von Sven Deutschländer ankam. Der Vortrag hatte zum Ziel einige alte Denkmuster beim SEO & SEA aufzulösen, mögliche Synergieeffekte im SEM aufzuzeigen und den Teilnehmern Informationen zum Thema AdWords Zertifizierung zu lieferen.

Sven beschrieb, dass viele KMUs eine „Omnipräsenz“ im Bereich SEM anstreben. Mit Hilfe der engen Verknüpfung von SEA und SEO Aktivitäten wurden in der Session Möglichkeiten beschrieben, genau diese starke Präsenz zu relevanten Suchanfragen zu erreichen. Des Weiteren wurden einige Thesen benannt, die helfen sollten eine gleichwertige Betrachtung von SEO und SEA Maßnahmen zu erreichen. Im SEA und SEO sollte demnach, wenn beide Disziplinen nicht aus einer Hand betrieben, zumindest ein regelmäßiger Austausch angestrebt werden, um eine gezielte Aussteuerung beider Kanäle zu ermöglichen und bestehende Marktpotentiale ideal auszunutzen.

Es gilt also zu prüfen, welche Keywords im SEA, im SEO oder in beiden Kanälen, d.h. in Kombination gut funktionieren. Die Verknüpfung des Adwords Kontos mit den Google Webmaster Tools (Bezahlte und organische Suchergebnisse-Bericht) kann genutzt werden, um eine gute Vergleichbarkeit beider Kanäle zu erreichen.

Darüber hinaus wurden weitere Use Cases benannt, in denen sich beide Kanäle beflügeln können:

- „not provided“ Lösungsansatz

- Linkbuilding Quellen über den Placement Bericht im Google Display Netzwerk zu finden

- Oder durch eine inhaltliche Überarbeitung einer Landingpage für SEO, welche sich auch positiv auf den Qualitätsfaktor der eigenen SEA Kampagnen auswirken können

Im nächsten Teil der Präsentation wurden Kriterien vorgestellt, was Agenturen bei der Zertifizierung als Google Partner oder auch bei der Mitarbeiter Zertifizierung zum AdWords Professional beachten sollten.

Crawling-Analyse: Wo ver(sch)wendet Google Crawling-Ressourcen? – Stephan Czysch

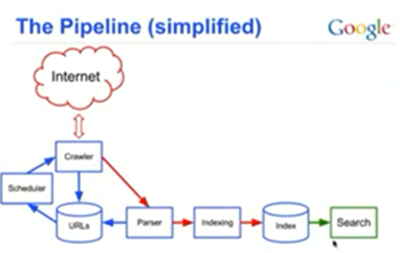

Stephan Czysch, einer von drei Geschäftsführern von Trust Agents, begann seinen Vortrag mit einer kurzen Erläuterung von Grundlagen hinsichtlich des Crawlings von Suchmaschinen. Unter anderem beschrieb er, dass ein Suchmaschinen-Crawler URLs mit verschiedenen Status Codes crawlen muss, um sicherstellen zu können, dass diese auch weiterhin relevant für die Indexierung sind. Dazu gehören u.a.:

- Verfügbare und nicht verfügbare URLs (bspw. 404)

- Weitergeleitete URLs (Bspw. 301)

- Von in der Indexierung ausgeschlossene URLs (bspw. meta robots noindex)

Nach einer kurzen Beschreibung der Google Pipeline (The Pipeline (simplified)) erläuterte er, dass Crawling nicht auch gleich einer Indexierung von URLs entspricht.

Mit Hilfe des meta robots Tag, welches User Agent spezifisch und auch im http Header übergeben werden kann, kann sichergestellt werden, dass Inhalte von der Indexierung ausgeschlossen werden. Um letztlich auch das Crawling einer URL zu verhindern, ging er anschließend auf die Konfigurationsmöglichkeiten bei der robots.txt ein, welche sich ebenfalls User Agent spezifisch definieren lässt. So werden alle Verzeichnisse und Dateipfade welche in der robots.txt nicht negiert werden zum Crawling zugelassen. Zusätzlich kann mit der Allow Anweisung gearbeitet werden, welche zwar nicht im robots.txt Standard definiert, aber sehr wohl von Google beachtet wird.

Nach einer Gegenüberstellung von verschiedenen Auswirkungen hinsichtlich Indexierung und Crawling bei Nutzung von Anweisungen wie der meta robots, der robots.txt und des canonical Tags ging Stephan auf einige konkrete Problemstellungen ein, die verdeutlichen sollten, dass es wichtig ist, irrelevante URLs nicht nur von der Indexierung, sondern speziell vom Crawling auszuschließen. So beschrieb er mit Hilfe der Crawling Statistiken aus den Google Webmaster Tools, dass nicht hohe Crawlraten, sondern vielmehr ein effizientes Crawling relevanter URLs entscheidend ist.

Die Daten der Google Webmaster Tools helfen zwar bei der Einschätzbarkeit von Crawling Schwierigkeiten auf der Webseite, um jedoch konkrete Probleme beim Crawling von Webseiten identifizieren zu können, sei der beste Weg die Logfile Analyse. So kann auch die Nutzung externer OnPage Tools nur helfen, Probleme auf der bestehenden Website zu identifizieren. Weitere relevante Einflussfaktoren wie Crawling Fehler durch extern verlinkte, alte oder nicht existierende URLs (URL Guessing) können dabei jedoch leider nicht beachtet werden.

Stephan zeigte auf den nachfolgenden Slides eine Schritt-für-Schritt Anleitung wie man Logfile Analysen auch in Excel durchführen kann, um sehr interessante Erkenntnisse über die Crawling Frequenz, Crawl-Präferenzen seitens Google und auch Crawling Probleme identifizieren lassen. Importiert man eine Logfile Datei in Excel und bereitet man die Daten ggf. mit den SEO Tools for Excel noch ein wenig auf, lassen sich somit interessante Fragestellungen beantworten:

- Wie häufig werden einzelne URLs von Google gecrawlt?

- Werden bestimmte Ordner präferiert vom Googlebot gecrawlt?

- Verändert sich die Zeitdifferenz beim Crawling durch den Googlebot?

- Welche URLs werden ggf. gar nicht gecrawlt? (Zusätzliche Aufbereitung notwendig: Bspw. mit Hilfe eines Vergleichs von Logfile URLs mit einer vollständigen XML Sitemap)

- Wie häufig werden relevante Seiten oder Top Landingpages im Vergleich zum Rest der Webseite gecrawlt?

Diese Fragestellung verdeutlichte er mit Hilfe einer Beispielanalyse, bei der festgestellt werden konnte, dass relevanten URLs eines Webauftritts nur mit einem Anteil von 8% gecrawlt wurden und somit wichtige Crawling-Ressourcen für weniger relevante Seiten seitens Google aufgewendet wurden.

Sein abschließender Tipp war darauf zu achten, das Crawling durch Google auf Websites gezielt zu steuern und sich mit dem Indexierungsmanagement eher nachgelagert zu beschäftigen.

Semantic Search: SEO, Marketing and Content for the Future – Svenja Hintz

Der Vortrag von Svenja Hintz hatte weniger einen operativen SEO Fokus, sondern beschäftigte sich ein wenig mit dem Großen Ganzen und dem Blick in die Zukunft. Nach einer kurzen Einführung in das Thema Semiotik („The Science of Sign“) beschrieb sie, wie Symbole kognitiv mit bestimmten Konzepten verknüpft werden. Als Resultat wissen bspw. wir Menschen durch den semantischen Zusammenhang welche Konzepte, also welche Bedeutungen mit einem bestimmten Symbol in Verbindung zu setzen ist. Ein abstraktes Konzept wird demnach letztlich durch Zeichen und Symbole genauer spezifiziert. So sind auch Wörter, Buchstaben, Sprache und Dialekte als Symbole zu verstehen, welche ein bestimmtes Konzept und infolgedessen eine Bedeutung spezifizieren. Nach dieser wirklich interessanten Einführung in das Thema Semiotik widmete sich Svenja in Ihrem Vortrag der Nutzung von Semantik im Bereich der Suche.

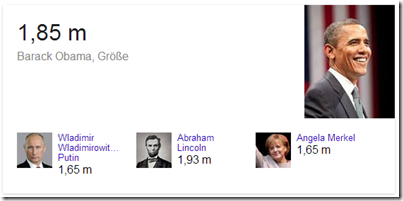

Sie machte deutlich, dass Google durch Themen wie Universal Search Integrationen verwandte Suchanfragen schon vor dem Hummingbird Update Semantik genutzt hat, um das Sucherlebnis und die Suchergebnisse weiter zu verbessern. Einfache Keywords sollen demnach von Entitäten, mit dem Versuch seitens Google Sprache (d.h. Symbole bzw. deren Bedeutung) besser verstehen zu können, abgelöst werden. Eine Entität bezeichnet dabei ein „Real Life Thing“, d.h. die Entität hat eine bestimmte Bezeichnung und auch bestimmte Eigenschaften, welche wenn diese bekannt sind zur Beantwortung einer konkreten Fragestellung genutzt werden können. Google entwickelt sich von der Suchmaschine also immer mehr zur „Antwortmaschine“.

Spätestens mit Einführung des Knowledge Graphs wird deutlich, dass Google bei der Erkennung von konkreten Fragestellungen besser wird und genaue Antworten zu Nutzerfragen liefern kann, wenn der Kontext der Fragestellung erkannt und durch passende Entitäten bedient werden kann.

Bsp. „how tall is barack obama“

Dabei können erst über den Kontext und die Beziehungen von Entitäten zueinander klare Ableitungen und Aussagen hinsichtlich des verfolgten Konzeptes getroffen werden. Die Kenntnis einer Vielzahl von verschiedenen Entitäten, deren Kategorisierung und die Kenntnis von Beziehungen dieser Entitäten untereinander innerhalb einer Ontologie ermöglichen es die „Grundstruktur des Seins“ also eines Themas oder einer Suchanfrage zu verstehen.

Eine Ontologie ist geprägt durch die enthaltenen Entitäten, welche durch Kanten und Knoten spezifiziert und verbunden werden:

Bei der Frage wie Google Entitäten kennen lernt benannte Svenja die folgenden drei Methoden:

- Ausgewählte Vertrauenswürdige Ressourcen (Bspw. Wikidataproject, Freebase)

- Google sammelt Daten in strukturierter Form (Bspw. schema.org)

- Nutzer stellt Daten strukturiert zur Verfügung (Bspw. Google Maps)

In der Diskussion mit den Teilnehmern wurde herausgestellt, dass online Informationsquellen eine hohe Informationstransparenz unterstützen müssen, um nicht langfristig in der Irrelevanz zu verschwinden. Dabei gilt es immer authentisch zu bleiben und die relevanten Aspekte, nach dem was, wie, wer und speziell dem warum zu beantworten. Abschließend gab Svenja einen Einblick in mögliche semantische Rankingfaktoren. Diese umfassten:

- Kontext: Standort, Interessen, Vorlieben

- Assoziationen: Verbindung zu Entitäten

- Beziehungen: Kanten, Schnittmengen

- Intention: Implizite Suchanfragen

- Sinngehalt: Semantische Auszeichnung

Dieser Vortrag war nicht nur wegen der thematischen Nähe zu meinem Studiengang der Informationswissenschaft einer meiner Session-Highlights an diesem Tag.

Vielen Dank an dieser Stelle an alle Vortragenden, das Orga-Team der SEO CAMPIXX und all die netten Leute, die ich während den zwei Tagen wieder sehen konnte. Hoffentlich bis im nächsten Jahr…

Wenn Sie weitere Fragen haben oder mehr Informationen benötigen, nehmen Sie direkt Kontakt mit mir auf: [email protected]

Mehr zur SEO CAMPIXX 2014 von uns gibt es hier

SEO CAMPIXX Tag 1 von David

SEO CAMPIXX Tag 1 von Patrick

SEO CAMPIXX Tag 2 von Patrick

Vielen Dank für tolle Feedback 🙂

Hallo Svenja,

wir haben für den tollen Vortrag zu danken 🙂

Der Vortrag gehörte für mich definitiv zu den Highlights der Campixx.. Ich hab mich sogar zu ein wenig Austausch mit Svenja und anderen im Anschluss „genötigt“ gefühlt.. 😉

Hat Spaß gemacht zuzuhören!