Linkfokussierung II : Seitenentwertung

Ich muss gestehen, dass auch ich selbst aufgrund des Nofollow-Links etwas an Kreativität eingebüßt hatte. Das Attribut war aber auch zu einfach einzusetzen und da hat man nicht mal gemerkt, dass man ineffizient gearbeitet hat. Aber Google war ja so nett uns das nette Ding wieder wegzunehmen und Schwupps,

man merkt wie kompliziert man einfache Probleme gelöst hat.Warum soll man alle Links, die auf mein Impressum zeigen per Nofollow-Link entwerten, wenn ich gleich die ganze Seite per Meta-Robots auf noindex/follow setzen kann. Ist doch viel einfacher und ruck zuck verteilt sich die ganze auf der Impressumsseite angesammelte Linkpower auf die von dort angelinkten Seiten. Und es ist so viel leichter…

Jetzt aber mal weg von der Einzelfallbetrachtung. Im vorherigen Posting hatte ich das grundsätzliche Ziel bereits beschrieben. Kurz, der interne Linkgraph soll auf die Seiten fokussiert werden, die auch vom Nutzer angefragt werden. Dabei habe ich folgende Methoden für die Lösung dieser Aufgabe vorgeschlagen:

- Entwertung der Links die auf die Seite zeigen durch

- Einsatz von IFrames

- Einsatz von Ajax/Javascript

- Entwertung der ganzen Seite

- Meta-Robot

- Canonical-Tag

Die Methoden der Linkentwertung habe ich auch hinreichend beschrieben, weswegen wir uns jetzt den Methoden der Entwertung der Seiten zuwenden.

Entwertung von Seiten

Hier gehen wir davon aus, dass es Seiten gibt die für Nutzer von Google irrelevant sind. Das sind alle Seiten, die keine Frage beantworten können, die ein Nutzer von Google stellt. Somit ziehen diese Seiten Rankgewicht von den Seiten ab, nach denen Nutzer in Google suchen.

Somit hängt die Entscheidung welche Seiten betroffen sind immer davon ab, welches Ziel ich verfolge. Nehmen wir das Beispiel Impressum. Wenn ich ein Onlineshop bin, wird kaum jemand über Google nach meinem Impressum suchen. Die Seite ist also für die Nutzer von Google uninteressant und ich kann sie entwerten. Bin ich aber ein Ladengeschäft und habe meine Adresse nur auf meinem Impressum hinterlegt, ist diese Seite sehr wohl für Nutzer von Google von Interesse. Ich sollte mir aber überlegen, ob ich die Seite lieber in Anschrift umbenenne. Ich hoffe aber, dass das Prinzip klar geworden ist.

Die beiden Methoden unterscheiden sich hinsichtlich der zusätzlichen Funktionen der Seite.

Meta-Robots

Der Einsatz vonempfiehlt sich bei allen Seiten, die man wegen rechtlichen Gründen anbieten muss (z.B. Impressum, AGBs etc.). Idee ist, dass die Seite nicht indexiert werden soll (NOINDEX), den Links auf der Seite aber sehr wohl gefolgt werden soll (FOLLOW). Die Hoffnung ist, dass sich das angesammelte Linkgewicht auf verlinkten Seiten vererbt. Man leitet die Linkpower also einfach durch diese Seiten auf die Zielseiten.

Es gibt aber noch andere Seitenartefakte, die vor allem bei größeren Seiten auftreten: Paginierungen von Archiven.

Das Problem bei Paginierungen ist, dass nur die erste Seite für Nutzer aus Google relevant sind. Das sieht man auch daran, dass Google in den Webmastertools die doppelten Titel von Archiven kritisiert. Wenn man aber einfach die Seitenzahl in den Titel übernimmt, wird man merken dass es keine Suchanfrage in der Form „Zweite Seite zum Thema X“ gibt. Sprich, die zweiten und folgenden Seiten eines Archivs beantworten keine Frage, die ein Nutzer an Google stellt.

Allerdings enthalten sie wertvolle Links auf Artikel, womit sie für den internen Linkgraph wichtig sind. Somit eignet sich die Entwertung der Seiten perperfekt. Die Seiten werden aus dem Index genommen, der Linkgraph bleibt aber intakt.

Als Beispiel verweise ich auf unsere Schauspielerarchive bei Videoload. Hier Sandra Bullock

Canonical-Tag

Das Canonical-Tag ist dafür gedacht doppelte Inhalte zusammenzuführen. Man kann es aber auch sehr gut dazu verwenden, um sogenannten Near Duplicate Content zu vermeiden. Die oben angesprochenen Paginierungen von Archivseiten könnte man auch per Canonical-Tag zurück auf die erste Seite verweisen. Da ich aber noch nicht getestet habe, ob Google dann dennoch die Links auf der Seite auswertet, setzen wir das Canonical-Tag in diesen Fällen nicht ein.

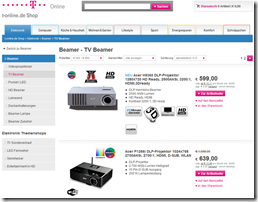

Es gibt aber andere Artefakte, die sich für den Einsatz vom Caninical-Tag eignen. Diese finden sich oft bei Seiten, die über Filter oder Sortierfunktionen verfügen. Als Beispiel dient mir hier der T-Online Shop. Hier folgende Seite:

Das bedeutet also, dass die URLs die durch diese Filter erzeugt werden, wieder keine Frage beantworten die ein Googlenutzer an Google stellt. Da wir aber bereits alle Beamer über die Paginierungsseiten angelinkt haben, sind diese durch den Preisfilter erzeugten Seiten für Google und den internen Linkgraph wertlos. Man kann sie also schlicht per Canonical-Tag auf die Kategorie TV-Beamer weiterleiten.

Ähnlich verhält es sich mit Sortierungen. Auch diese Seiten kann man ohne Probleme per Canonical-Tag auf die jeweilige Default-Version der Seite umleiten lassen. Sprich jede Seite, die für die Nutzer meiner Seite wichtig aber nicht für Nutzer von Google relevant sind, kann man per Canonical-Tag auf die jeweils Google-relevante Version verweisen lassen.

WICHTIG: Hierbei aber bitte unbedingt prüfen, ob die Filter wirklich nicht relevant sind.

Im Beispiel der Beamer sind die Filter nach Marke durchaus suchrelevant, weshalb die Seite zu TV-Beamern von Acer nicht per Canonical-Tag auf die Seite der TV-Beamer ohne Herstellerfilter verweist.

Nachfolgend noch eine tabellarische Übersicht zum Themen:

Zum Abschluss bleibt mir nur zu hoffen, dass Euch diese kleine Serie gefallen hat. Und natürlich interessieren mich Eure Methoden zur Fokussierung des internen Linkgraph. Fragen, Kommentare und Anmerkungen sind willkommen. Also los!

Schreibt Eure Fragen einfach an: [email protected]

Lest auch Teil I – Linkfokussierung I : Linkentwertung

(Bild: Stock Photo ID: 52131652 Copyright: VLADGRIN)

Es handelt sich hier um die Kategorie TV-Beamer, die aber per Filter auf Beamer von 500,00 € bis 800,00 € eingeschränkt ist. Nun sind aber selbst uns die Suchanfragen nach Beamer von 500 bis 800 Euro zu longtailig 😉

Es handelt sich hier um die Kategorie TV-Beamer, die aber per Filter auf Beamer von 500,00 € bis 800,00 € eingeschränkt ist. Nun sind aber selbst uns die Suchanfragen nach Beamer von 500 bis 800 Euro zu longtailig 😉

Müssen bei der Verwendung des Canonical Tags nicht beide Seiten absolut bzw. weitgehendidentisch sein und sich lediglich in der URL unterscheiden? Bei dem o.g. Preisfilter könnte sich das schon stark unterscheiden.

Hallo Jens,

danke für die interessanten Posts!

Mich würde interessieren, wie ihr die Erreichung bzw. Ermittlung eines möglichst optimalen Linkgraphen erreicht. Nutzt ihr dafür ein Tool um die Menge bzw. die Qualität der internen Links auf eine Seite zu ermitteln?

Bei einer so großen Anzahl an Dokumenten kann man sicherlich licht den Überblick verlieren.

Hi Jens. Super Serie. Da ich im Gegensatz zu dir eher mit kleineren Konstrukten zu tun habe oder bei meinen Kunden aufwändige Anpassungen in der Software nicht möglich sind, ist noindex, follow mein bester Freund. Zumal es grade bei WordPress ganz easy mit wpseo geht.

Ich finde die Variante canonical bei den Pagern nicht schlecht…jedenfalls funktionierts bei uns…denn du hast immer mal gute externe Links auf die Seiten 2-x…die im „normalfall“ ja auf noindex steht.

@Jens & Frank

Für WordPress gibt’s auch ein Plugin namens Robots Meta vom guten Joost de Valk. Damit kann man für jeden Artikel / jede Seite die Robot-Einstellungen (index, follow; index, nofollow; noindex, follow; noindex, nofollow) separat vornehmen.

Hallo Jens,

erstmal vielen dank für den artikel, auch wenn ich etwas spät drann bin.

Ein Frage hätte ich aber, wie verhällt es sich mit Seiten, die alle Links auf rel=“nofollow“ laufen haben, im Meta aber stehen haben.

Wer bildet da den Override?

Logischerweise sollte das nofollow im Link ja größeres Gewicht haben oder.

Grüße Max

Hallo Max,

wenn die Links alle auf nofollow stehen, sind sie auch nofollow. Die Seite macht dann aber auch nicht wirklich viel Sinn. Hast Du mal einen Use-Case für so etwas?

VG; Jens

Hallo Jens,

Irgendwie ist ein Teil aus meinem Comment verschwunden.

Ich meinte eine Seite hat in den Meta ( robots content=“INDEX, follow“ ) stehen, hat aber alle externen Links mit rel=“nofollow“ direkt ausgewiesen.

Somit müsste der meta-tag, für die Links, ja ignoriert werden oder.

Einen Use-Case hätte ich, die Feeds von rss-nachrichten.de

Z.B. dieser hier https://bit.ly/bGsau5

Ja da hast du vollkommen recht.

Es hat für mich nur komisch ausgesehen, dass man einerseits alles auf index follow setzt, zum anderen aber gleichzeitig die links mit nofollow entwertet.

Du aber ich habe eine andere Frage, die hier ganz gut reinpasst.

Ich betreue einen Strato-Shop und habe ein DC Problem, da Google ja gern komisches Zeug indexiert, bei mir gleiche Inhalte unter verschiedenen ( dymischen ) Ordnern.

Normalerweise, würde ich diese Ordner via robots.txt sperren und dann löschen lassen.

Das problem ist, dass ich bei Strato keinen Zugriff auf die robots.txt bekomme.

Meine einzige Möglichkeit wäre den noindex Tag einzufügen, dieser ist dann aber Seitenübergreifend, für alle Contentseiten.

Wenn ich das tue und die Löschung beauftrage, dauert diese etwa eine Nacht lang, danach würde ich den Tag wieder in Index, follow ändern. In der Zwischenzeit wird der Bot aber meine Seite crawlen und feststellen, dass alle Seiten auf noindex stehen.

Meine Frage wäre:

Könnte dieses kurzfristige noindex setzten, spätfolgen mit sich bringen, in der Form das ich damit alle Seiten aus dem Index befördere?

Danke für deine Hilfe und viele Grüße

Maxim