SEO Tool Test: SISTRIX Optimizer im Alphatest II

Mein Name ist David Richter. Seit Anfang 2010 bin ich Junior Manager SEO bei der Deutschen Telekom AG. Im Team von Jens Fauldrath berate ich vorrangig die Plattform zum Thema Spiele Download, das Spieleportal der Deutschen Telekom AG sowie weitere Online Assets der DTAG.

Neben meinen operativen Aufgaben konzipiere und halte ich interne Schulungen zum Thema SEO für redaktionelle Inhalte im Shop Umfeld und verantworte teamintern das Thema strukturierte Daten für Google Shopping sowie die Universal Search Video.

Xing: https://www.xing.com/profile/David_Richter9

Twitter: https://twitter.com/sb_mkt

Blog : http://www.information-mgmt.de/

SISTRIX Optimizer Alphatest II:

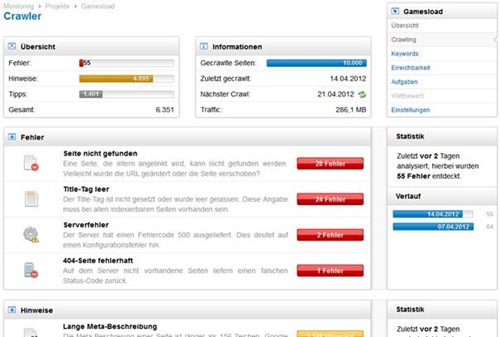

Der Crawling Bericht

Wie bereits im ersten Teil unseres Alphatests beschrieben, erhält man in diesem Bereich sehr viele wichtige Daten. Der SISTRIX Optimizer stellt eine gute Alternative bzw. Ergänzung zu den Google Webmaster Tools dar. Der Vorteil am Analyzer ist, dass man keine Verifizierung der Domain durchführen muss. Damit eignet sich das SISTRIX Tool natürlich auch, um Projekte zu Wettbewerbern einzustellen, um mehr über Crawling Probleme und den Stand der Optimierung bei der Konkurrenz in kurzer Zeit zu erfahren.

Tipp: Zu beachten ist, dass man bei der Projekterstellung zwischen Domain, Subdomain und sogar auch Verzeichnis unterscheiden kann. Ja nachdem welche Teile der Domain analysiert werden sollen, müssen also entsprechende Konfigurationen des Crawlers vorgenommen werden.

Crawling Fehler

Die Funktion Title-Tag leer führt URLs auf, bei denen kein Title-Tag gesetzt ist bzw. dieser leer gelassen wurde. Da der Titel ein sehr wichtiges Ranking- sowie Usability-Kriterium ist, gibt die Funktion wichtige und gute Hinweise auf mögliche Optimierungspotentiale innerhalb der eigenen Seite.

Die Analyseergebnisse zu Crawling Fehler können auf zwei Arten sehr gut genutzt werden. Zum einen kann versucht werden, Fehlermuster zu erkennen, die i.d.R. dann mit einer größeren technischen Anforderung gefixt werden müssen. Zum anderen gibt es jedoch auch Fehler, bei denen kein Muster zu erkennen ist oder die ggf. nicht durch eine Anforderung berichtigt werden können.

Anwendung: Im Fall von Gamesload wurden insgesamt 34 Seiten ohne Title Tag gefunden. Beim Großteil der Fehler fällt auf, dass die URL-Struktur nahezu identisch ist, was nahe legt, dass es sich hierbei um ein Fehlermuster handelt. Schaut man sich die Seiten an, so wird ersichtlich, dass es sich hierbei um einen Teil der Bildergalerien von Produktseiten handelt, welche nicht für Rankings geeignet sind. Diese Seiten lassen sich einfach per Meta-Robots-Tag sperren.

Bei der Funktion Seite nicht gefunden werden Seiten detektiert, die einen 404 Status Code ausgeben und somit einen Hinweis auf fehlerhafte Verlinkungen geben.

Anwendung: Beim Test mit Gamesload wurden bei 10.000 gecrawlten Seiten (von ca. 50.000 Seiten) 28 Fehler detektiert. Die Analyse ermöglichte die Identifizierung eines Fehlers in einem Template, der daraufhin beseitigt werden konnte.

Die Funktion Inhalte doppelt vorhanden gibt sehr gute Hinweise, ob Inhalte unter mehr als einer URL erreichbar sind. Dies ist wichtig, um Duplicate Content Probleme zu erkennen und aufbauend auf die Analyseerkenntnisse Ableitungen für die Plattform oder die Informationsarchitektur zu treffen.

Mit Hilfe der Funktion 404-Seite fehlerhaft wird getestet, wie sich der Server beim Aufruf nicht existenter URLs verhält: Wird richtigerweise ein 404 Status Code ausgegeben oder fälschlicherweise ein 200er Status Code?

Tipp: Crawling Fehler, welche man als nicht zutreffend erachtet, können ausgeblendet und im Einstellungsbereich verwaltet werden.

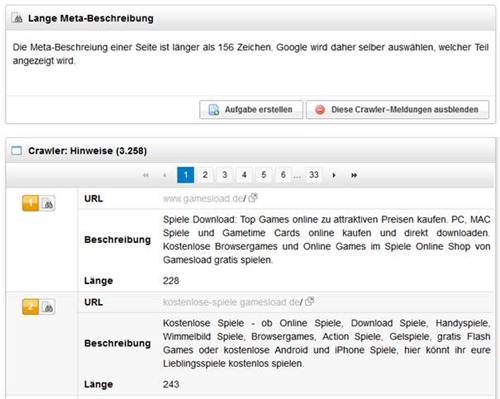

Crawling Hinweise

Die Funktionen Lange Meta-Beschreibung sowie Sehr langer Titel führen URLs auf, die entgegen den Best Practices zu viele Zeichen enthalten. Dies ist sehr hilfreich, um Seiten zu identifizieren, welche hinsichtlich Nutzerbelange und Anzahl relevanter Keywords optimierungsbedarf haben. In dieselbe Kerbe schlagen die Features Kurze Meta-Description, Gleicher Title und gleiche Meta-Description. Letztere können zusammen mit Analyseerkenntnissen der Funktion Gleiche Überschrift einen Aufschluss über Duplicate Content geben.

Anwendung: Bei Gamesload wurden 1.376 Hinweise gefunden, welche Anhaltspunkte zur Optimierung der Titel Tags geben können. Die Anzahl der Fehler kann hier sehr hoch sein, da im Fall von Gamesload immer der Brandname ans Ende des Title Tags gestellt wird

Im Fall von Gamesload wurden insgesamt 42 Fälle entdeckt, bei denen das H1 Tag nicht ein-eindeutig vergeben wurde. Dies liegt daran, dass sich die Namen der Games häufig in Hauptversionen und Subversionen unterteilen und diese zwei Aspekte auch im Produkttemplate voneinander getrennt sind. Hier wird der Titel als H1 ausgezeichnet und der Alternativtitel als H2. Dieses Problem lässt sich sehr einfach mit der Anpassung des Templates ändern.

Weiterhin wurden bei Gamesload gleiche Title und Description auf diversen URLs identifiziert. Aufgrund des Berichts wurde ersichtlich, dass es sich bei diesen Seiten u.a. um Archive handelt, die nicht in den SERPs enthalten sein sollen. Dank dieser Ergebnisse konnte die Anforderung adressiert werden, betreffende Seiten per meta robots=“noindex, follow“ zu sperren.

Als Ergebnis der Funktion Hohe Ladezeit bekommt man eine Reihe von URLs der zu analysierenden Domain zurückgegeben, die eine Ladezeit über 5 Sekunden haben. Da die Website Performance auf Grund des starken Einflusses auf die Usability immer mehr als relevanter Rankingfaktor gesehen wird, sind Optimierungshinweise in diesem Bereich sehr wertvoll und wichtig. Gegenüber den Daten aus anderen Tools hat dieser Bericht den Vorteil, dass er eine Vielzahl von URLs auflistet und die Analyse regelmäßig wiederholt wird. Um herauszufinden, was die Gründe für die Performanceprobleme sind, empfiehlt es sich auf weitere Tools wie PageSpeed zurück zu greifen. Mit dem SISTRIX Optimizer erhält man also einen idealen Startpunkt für die Performanceoptimierung.

Mi Hilfe der Funktion Keine Links deckt das Tool die URLs innerhalb der zu analysierenden Domain auf, die über keine internen oder externen Links verfügen. Da Linkflächen meist geschaffen werden müssen und nicht in ausreichendem Maße vorhanden sind, sollte man versuchen, alle wichtigen Seiten innerhalb der eigenen Domain für die interne oder externe Verlinkung zu nutzen.

Anwendung: Während des Crawlings von Gamesload wurden 33 Hinweise auf Seiten ohne Links gefunden. Es handelte sich jedoch um Seiten, die kurzeitig nicht erreichbar waren und daher vor dem SISTRIX Crawler keine Inhalte führten. Hier konnte also mehr ein Aufschluss über Serverprobleme als Linkpotentiale gewonnen werden.

Mit Hilfe der Analyse Sehr dynamische URL können schnell Probleme in der URL-Struktur aufgedeckt werden. Da URLs immer aus dem System heraus gebildet werden, muss im Anschluss an die Analyse eine Anforderung an das System formuliert werden, die sicherstellt, dass solche URLs nicht generiert und verwendet werden. Bestenfalls sollte hier also eine robuste URL Logik ohne die Verwendung von Parametern gewählt werden. Je nach Änderung der Inhalte aufgrund der Parameter ist ebenfalls an weitere Maßnahmen wie die Implementierung von Canonical Tags zu denken.

Die Funktion Interne Weiterleitung gibt Auskunft darüber, ob interne Weiterleitungen bestehen und folglich nicht die bestmögliche Vererbung der Linkkraft gewährleistet wird.

Anwendung: Auf Gamesload wurden 302 Redirects gefunden, die dazu führen, dass keine Linkpower auf die verlinkte Seite übertragen wird. Dadurch konnten URLs herausgefunden werden, bei denen die Redirects auf den 301-Statuscode geändert werden müssen.

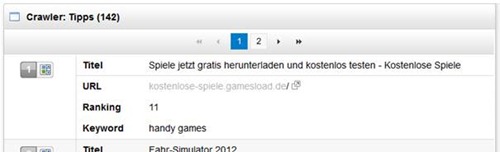

Der SISTRIX Optimizer prüft mit der Funktion Keyword nicht im Titel, in wie weit sich eine der eigenen Seiten zu interessanten Keywords zwischen Platz 11 und 20 befindet. Kann das Tool hier eine URL finden, wird zusammen mit dem Keyword ein Hinweis zur Titel-Optimierung gegeben.

Hinweis: Wenn eine Seite für eine Fehlschreibweise rankt, wird die Fehlschreibweise als Tipp für den Title aufgeführt. Weiterhin ist darauf hinzuweisen, dass der Keywordcheck im exact match erfolgt.

Anwendung: Diese Funktion ist sehr hilfreich, wenn man feststellen möchte, ob man mit dem Hinzufügen des Keywords in den Titel und die Angliederung von weiteren Maßnahmen einige Ranking Quick Wins realisieren kann. Ein ergänzender Abgleich der Linkmetriken im Wettbewerbsumfeld kann sinnvoll sein, um zu prüfen, in wie weit Linkbuilding eine solche Seite einige Plätze weiter nach vorne bringen kann.

Die Funktion Nicht indexierbare Inhalte prüft, welche URLs für eine Indexierung bei Google ausgeschlossen wurden. Dies ist i.d.R. gewollt, jedoch kann es gerade in großen Unternehmen immer mal wieder passieren, dass ungewollt wichtige Seiten mit noindex ausgezeichnet werden und so Rankingverluste die Folge sind.

Anwendung: Im Fall von Gamesload wurden 35 Hinweise auf gesperrte Seiten gegeben. Diese sind alle bewusst gesperrt, insofern besteht hier kein direkter Handlungsbedarf. Dennoch ist diese Funktion sehr gut geeignet, um ein stetiges Monitoring über die Vorkommnisse bei der Analyse aufzusetzen und bei Auffälligkeiten eine Tiefenanalyse zu machen.

Innerhalb der Analyse URL mit Großbuchstaben werden URLs ausgegeben, die Großbuchstaben in den URLs enthalten. Diese können Crawlern die Verarbeitung der URL erschweren und sind wichtig, um Hinweise darüber zu bekommen, ob die URL Zusammensetzung generell oder in kleinen Teilen der zu analysierenden Domain nicht optimal ist. Lassen sich hier Fehler-Muster erkennen, kann man auch hier technische Anforderungen an die Plattform ableiten. Handelt es sich um individuelle Vorkommnisse, sollte man versuchen die Probleme individuell zu lösen.

Anwendung: Bei Gamesload wurden 35 Tipps zu „URL mit Großbuchstaben“ gegeben. Da das Fehlermuster und die betroffenen Seiten absolut identisch zur Analyse Sehr dynamische URL sind, konnte gleich eine Vielzahl an Fehlern ignoriert werden, da hierfür bereits eine Anforderung an die Plattform formuliert wurde.

Mit Hilfe der Funktion Ungerichtete interne Verlinkung sollen Hinweise auf Optimierungsmöglichkeiten bei der internen Verlinkung gegeben werden. Da auch der interne Linkgraph für ein gutes Ranking wichtig ist, gilt es die für die Zielsetzung relevanten Seiten auch gut intern zu vernetzen.

Anwendung: Beim Test mit Gamesload konnten 4 Seiten identifiziert werden, die stark intern verlinkt werden. Bei einem Analyseergebnis stellte sich heraus, dass es sich bei dem Linktext „Startseite“ mit insgesamt 4407 Links um den ersten Pfad des Breadcrumbs handelt. Hier sollte also der Linktext mit einem relevanten Keyword besetzt werden.

Im dritten und letzten Teil unseres Alphatest widmen wir uns dem Keyword Bericht und geben ein zusammenfassendes Fazit zum SISTRIX Optimizer.

David Richter: